Red Teaming ist ein strukturierter Prozess, bei dem eine unabhängige Gruppe, das so genannte "Red Team", die Perspektive eines realen Gegners einnimmt, um Schwachstellen zu ermitteln und die Wirksamkeit der Sicherheitskontrollen, -prozesse und -mitarbeiter eines Unternehmens zu testen. Im Gegensatz zu standardmäßigen Sicherheitsbewertungen oder Penetrationstests werden beim Red Teaming umfassende Cyberangriffe, physische Einbrüche oder Social-Engineering-Taktiken simuliert, wobei oft über längere Zeiträume hinweg heimlich und beharrlich vorgegangen wird.

Red Teaming gilt nicht nur für Softwareprodukte: ist ein vielseitiger Ansatz, um die Widerstandsfähigkeit einer Vielzahl von Systemen, Organisationen und Prozessen zu prüfen und zu verbessern. Ursprünglich aus militärischen und nachrichtendienstlichen Operationen stammend, beinhaltet Red Teaming die Simulation von gegnerischen Taktiken, um Schwachstellen zu identifizieren, sei es in der physischen Sicherheit, in Geschäftsabläufen, in der strategischen Planung oder sogar in Social-Engineering-Szenarien.

Rechtliche Aspekte und Vorsichtsmaßnahmen

Vor der Durchführung eines Red Teaming-Projekts müssen mehrere rechtliche Aspekte sorgfältig geprüft werden, um unbefugte oder kriminelle Aktivitäten zu vermeiden.

Dies ist besonders wichtig, da diese tief greifenden Eingriffe und Tests häufig von spezialisierten externen Parteien des Unternehmens durchgeführt werden.

Clear, written authorization is essential, typically in the form of a signed Rules of Engagement (RoE) document, which outlines the scope, permitted techniques, targets, and limitations of the engagement. This ensures compliance with relevant laws, such as the Computer Fraud and Abuse Act (CFAA) or data protection regulations (e.g., GDPR), and helps prevent legal issues arising from actions such as unauthorized data access, service disruption, or privacy violations. All activities should respect confidentiality, intellectual property, and privacy rights, and avoid impacting third parties. Additionally, non-disclosure agreements (NDAs) are typically required to protect sensitive information, and documentation of consent from all stakeholders is critical to demonstrate due diligence in case of legal scrutiny.

Red Teaming für Produktdesign

Red Teaming bei der Entwicklung neuer Produkte verringert das Risiko, stärkt das Design, fördert die Innovation und verbessert die Marktreife, indem es unsichtbare Schwachstellen aufdeckt und das Denken des Status quo in Frage stellt, bevor das Produkt den Kunden erreicht.

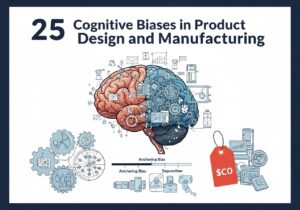

- Identifiziert Schwachstellen und blinde Flecken: Red Teamer gehen das Produkt aus einer gegnerischen Perspektive an. Sie bewerten das Design kritisch und decken Sicherheitsmängel, Benutzerfreundlichkeit oder ergonomische Probleme, technische Schwachstellen oder eine falsche Marktausrichtung auf, die das ursprüngliche Marketing- oder F&E-Team möglicherweise übersehen hat.

- Annahmen in Frage stellen: Produktteams können sich zu sicher sein oder zu sehr in ihre Designentscheidungen investieren. Red Teams stellen zentrale Annahmen in Frage und fordern die Teams auf, ihre Entscheidungen zu begründen und gegebenenfalls zu revidieren.

In any structured Phase-Gate development process, these results should be included in risk Management files and usability assessments.

- Simulation realer Bedrohungen: Bei Produkten, die mit Sicherheit zu tun haben (Software, IoT usw.), agieren die Red Teams als potenzielle Hacker oder Konkurrenten. Dieser Drucktest zeigt, wie sich ein Produkt in realistischen, negativen Szenarien verhält.

- Verbessertes Risikomanagement: Durch das Aufzeigen potenzieller Fehlerquellen ermöglicht Red Teaming den Teams eine proaktive Risikominderung vor der Markteinführung, wodurch die Wahrscheinlichkeit kostspieliger Rückrufe, negativer Publicity oder Sicherheitsverletzungen verringert wird.

- Verbesserte Produktstabilität und -zuverlässigkeit: Iteratives Red Teaming stellt sicher, dass das Endprodukt robust und zuverlässig ist und unerwartete Situationen besser bewältigen kann, was das Vertrauen und die Zufriedenheit der Verbraucher erhöht.

Und als Global Company und Marketing Benefits

- Förderung der Innovation: Konstruktiver Widerstand fördert die Kreativität. Durch das Aufdecken anfänglicher Designgrenzen inspiriert Red Teaming zu wettbewerbsfähigen Unterscheidungsmerkmalen.

- Erleichtert die disziplinübergreifende Zusammenarbeit: Red Teaming muss grundsätzlich Mitglieder außerhalb des unmittelbaren Produktteams einbeziehen (z. B. Sicherheit, Recht, Kundendienst). Dies erweitert die Perspektiven und stärkt das gesamte Design- und Entwicklungsprojekt.

- Objektives Feedback: Als Außenstehende sind die Red Teams weniger von der Unternehmenspolitik oder der Verbundenheit mit dem Projekt beeinflusst und können unvoreingenommene Kritik üben.

Beispiel für eine Red Teaming-Methodik

Und dabei eine professionelle Haltung bewahren:

Objektive Kritik: nicht um zu sabotieren, sondern um zu stärken, indem Annahmen in Frage gestellt werden.

Feindselige Denkweise: Denken Sie wie raffinierte Angreifer, Konkurrenten oder unzufriedene Benutzer.

Fachübergreifende Zusammenarbeit: Einbeziehung technischer, wirtschaftlicher und sozialer Aspekte.

Red Teaming bei der Entwicklung neuer Produkte ist ein sich wiederholender Zyklus aus kreativen Herausforderungen, Simulationen, Analysen und Lernprozessen, bei dem gegnerische Erkenntnisse in ein besseres, sichereres und robusteres Produkt umgesetzt werden:

|

1. Projekt-Scoping und Zieldefinition

|

2. Sammeln von Informationen (Aufklärung)

|

3. Planung des roten Teams

|

4. Simulation und Ausführung

Die Haupttätigkeit selbst:

- Durchführung von Übungen: technische Angriffe: Versuche, die Produktsicherheit auszuschalten - Ausnutzen von Konstruktionsfehlern, Testen von Hardware-/Software-Schwachstellen.

- Nichttechnische Angriffe: Versuchen Sie es mit Social Engineering, Fehlinformationskampagnen oder Missbrauch der Geschäftslogik.

- Marktangriffe: Simulation von Markenimitation, Preisangriffen oder unethischen Strategien der Konkurrenz.

... ohne zu vergessen, jeden Schritt zu dokumentieren, alle Methoden, Werkzeuge, Ergebnisse und Beweise festzuhalten.

5. Analyse

|

6. Feedback & Nachbereitung

|

Mehr dazu

- Penetrationstests (Pentesting)

- Social-Engineering-Angriffe

- Emulation des Gegners: MITRE ATT&CK-Rahmenwerk

- Entwicklung von Exploits

- Analyse und Umgehung des Netzwerkverkehrs

- Techniken nach der Ausbeutung: Privilegieneskalation, seitliche Verschiebung

- Befehls- und Kontrollinfrastruktur (C2)

- Phishing und Bereitstellung von Nutzdaten

- Red Team Tools und Frameworks: Cobalt Strike, Metasploit

- Umgehung von Sicherheitskontrollen: AV/EDR-Umgehung, Persistenz-Techniken

Externe Links zu Red Teaming

Internationale Standards

Interessante Links

(Bewegen Sie den Mauszeiger über den Link, um unsere Inhaltsbeschreibung anzuzeigen)

Glossar der verwendeten Begriffe

Define Measure Analyze Improve Control (DMAIC): Eine datengesteuerte Qualitätsstrategie, die in Six Sigma zur Prozessverbesserung verwendet wird und aus fünf Phasen besteht: Identifizierung des Problems, Messung der aktuellen Leistung, Analyse der Daten zur Identifizierung der Ursachen, Verbesserung der Prozesse auf Grundlage der Erkenntnisse und Kontrolle der zukünftigen Leistung zur Aufrechterhaltung der Verbesserungen.

Internet of Things (IoT): Ein Netzwerk miteinander verbundener Geräte mit eingebetteten Sensoren, Software und anderen Technologien, die es ihnen ermöglichen, Daten über das Internet zu sammeln und auszutauschen und so die Automatisierung, Überwachung und Steuerung verschiedener Prozesse und Systeme zu erleichtern.

Non-Disclosure Agreement (NDA): Ein Rechtsvertrag, der eine vertrauliche Beziehung zwischen den Parteien begründet und die Weitergabe bestimmter Informationen an Dritte untersagt. Er wird häufig zum Schutz vertraulicher Informationen verwendet, die bei Geschäftsverhandlungen oder Kooperationen ausgetauscht werden.

Red Teaming ist für den Produktentwicklungsprozess potenziell störend!!